基于条件对抗网络的图像到图像转换(Pix2Pix)

论文主体思路

论文主要贡献

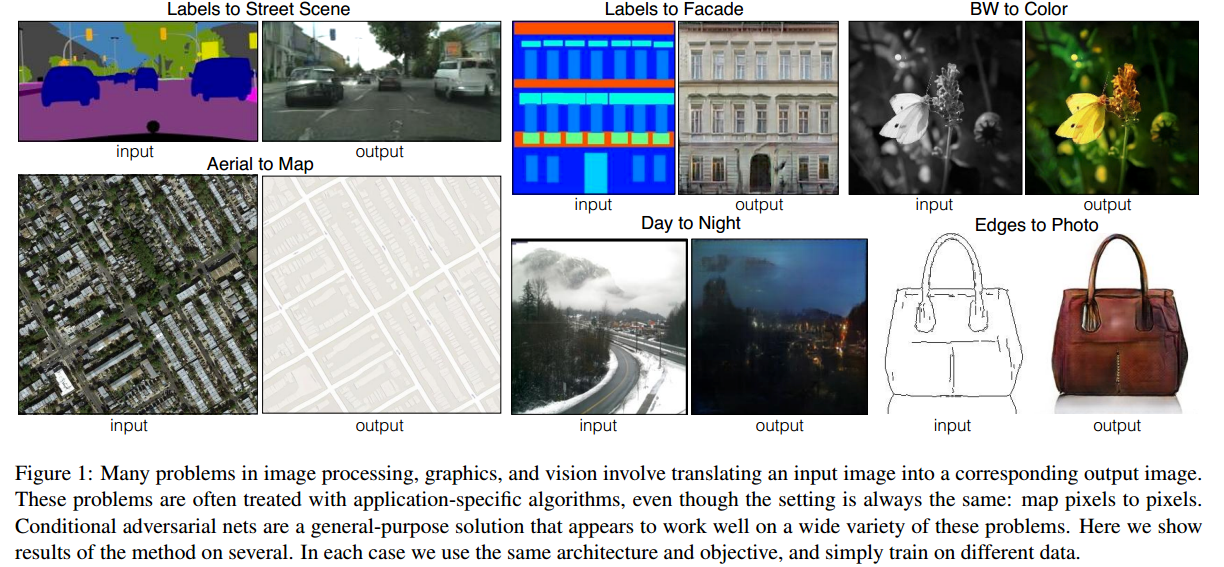

- 研究了条件对抗网络作为图像到图像翻译问题的通用解决方案。该网络不仅学习了从输入图像到输出图像的映射,还学习了一个损失函数来训练这个映射,这使得使用一个通用框架就能解决很多不同类型的问题成为可能。

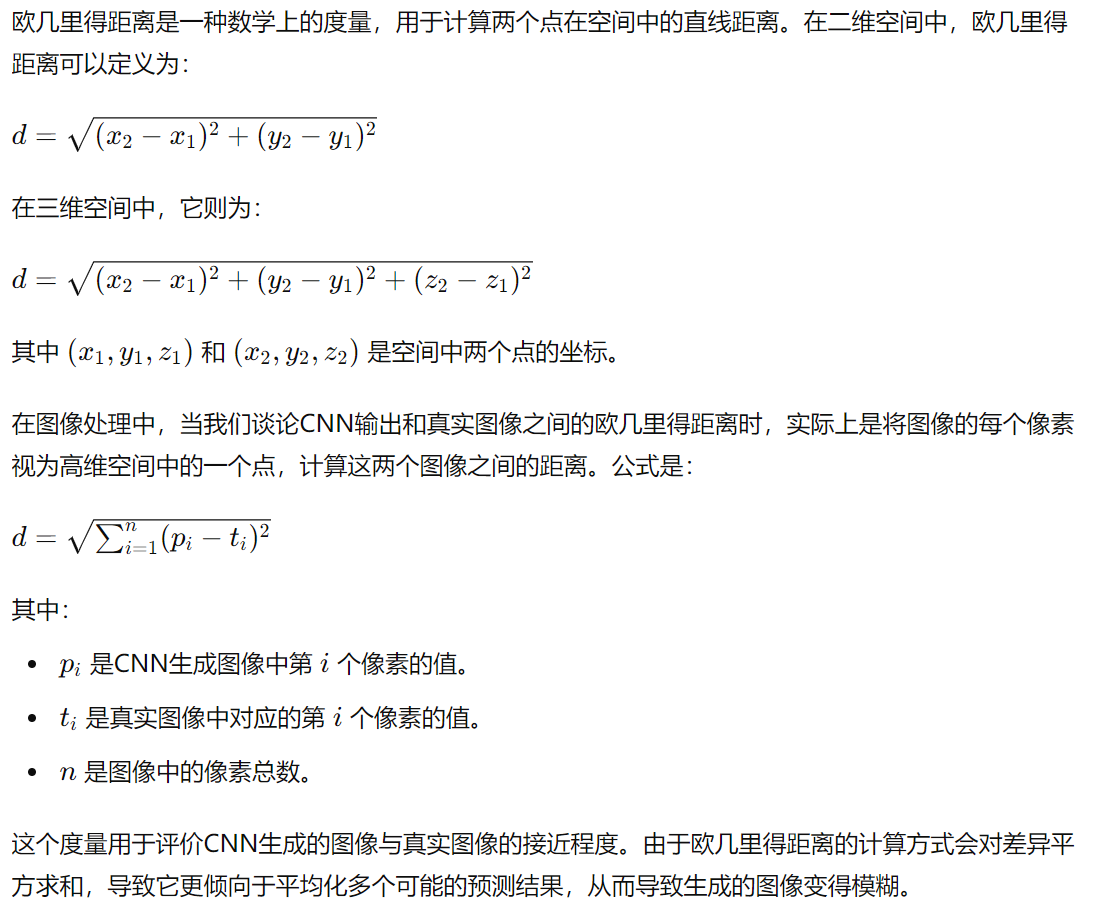

- 当我们使用一种简单的方法让卷积神经网络(CNN)最小化它对图像预测与真实图像之间的欧几里得距离时,结果往往会变得模糊。这是因为欧几里得距离损失函数会使CNN在所有可能的预测中求平均,从而导致模糊的结果。找到合适的损失函数,迫使CNN生成我们真正想要的输出—例如清晰、逼真的图像—是一个尚未解决的问题,需要专业知识和经验。换句话说,设计一个能够指导CNN生成更符合预期的清晰图像的损失函数是一项具有挑战性的任务。

- GAN(生成对抗网络)通过一种独特的学习方式来生成更逼真的图像。它包括两个部分:一个是“判别器”,它的任务是判断一张图像是真实的还是由模型生成的;另一个是“生成器”,它试图生成足够逼真的图像以骗过判别器。模糊的图像很容易被判别器识别为假,因为它们不像真实的图像那么清晰。这种逼迫生成器必须输出清晰、细节丰富的图像。由于GAN学习过程中会根据数据自适应损失函数,它能够应用于很多传统上需要不同类型损失函数的任务,比如图像修复、风格迁移等。这样,GAN可以在很多不同的图像生成任务中表现出色。

- 条件GAN(条件生成对抗网络)与普通GAN的不同之处在于它的损失是通过学习得来的。这意味着条件GAN可以根据不同的任务,动态地调整对生成图像的要求。具体来说,条件GAN可以识别并惩罚生成的图像与目标图像之间的任何差异,无论是颜色、形状还是纹理。换句话说,它可以根据我们提供的条件,灵活地适应并生成我们想要的特定类型的图像。

Conditonal GANs

- 对于生成器,使用了基于U-Net的架构,对于鉴别器,使用了卷积的PatchGAN分类器,它只在图像补丁的尺度上惩罚结构。

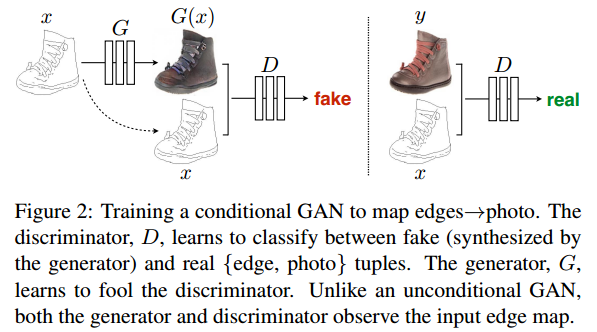

- GAN是一种生成模型,它学习从随机噪声向量z到输出图像y的映射(G:z—>y),相比之下,条件GAN学习从观测图像x和随机噪声向量z到y(G:{x,z}—>y), 生成器G经过训练,产生的输出不能被对抗训练的鉴别器D与“真实”图像区分开来,而鉴别器D被训练得尽可能地检测生成器的“伪造”图像。这个训练过程如图2所示。

评价指标

评价合成图像的质量是一个复杂的问题。传统的评价方法,比如逐像素的均方误差(MSE),只能简单地计算每个像素之间的差异。这种方法不能理解图像整体的结构、细节或者纹理,因为它没有考虑像素之间的关系或分布。简单来说,MSE只看单个像素的差异,而不看图像整体的结构和细节变化。因此,这种方法无法有效地衡量合成图像中更高级别的特征,比如图像的整体形状、纹理或者视觉上的一致性。

附录与补遗

欧几里得距离

关于文献

题目及期刊

题目:Image-to-Image Translation with Conditional Adversarial Networks

基于条件对抗网络的图像到图像转换

期刊:CVPR

作者信息

作者:Phillip Isola

发表时间

日期:2017年

阅读时间

日期:2024年8月14日

开源代码及其它

GitHub地址:https://github.com/phillipi/pix2pix

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 YuJiang's Long Holiday!