注意力U-Net:学习在哪里寻找胰腺(Attention U-Net)

论文主体思路

论文主要贡献

- 提出了一种Attention Gate(AG)模型的医学成像,自动学习聚焦在不同形状和大小的目标结构。经过AGs训练的模型隐式学习抑制输入图像中的不相关区域,同时突出显示对特定任务有用的显著特征。这使我们能够消除使用级联卷积神经网络(CNN)的显式外部组织/器官定位模块的必要性。

- AGs可以很容易地集成到标准的CNN架构中,如U-Net模型,以最小的计算开销,同时提高模型的灵敏度和预测精度。

- 在两个大型CT腹部数据集上对所提出的注意力U-Net架构进行了多类图像分割的评估。

Attention U-Net框架

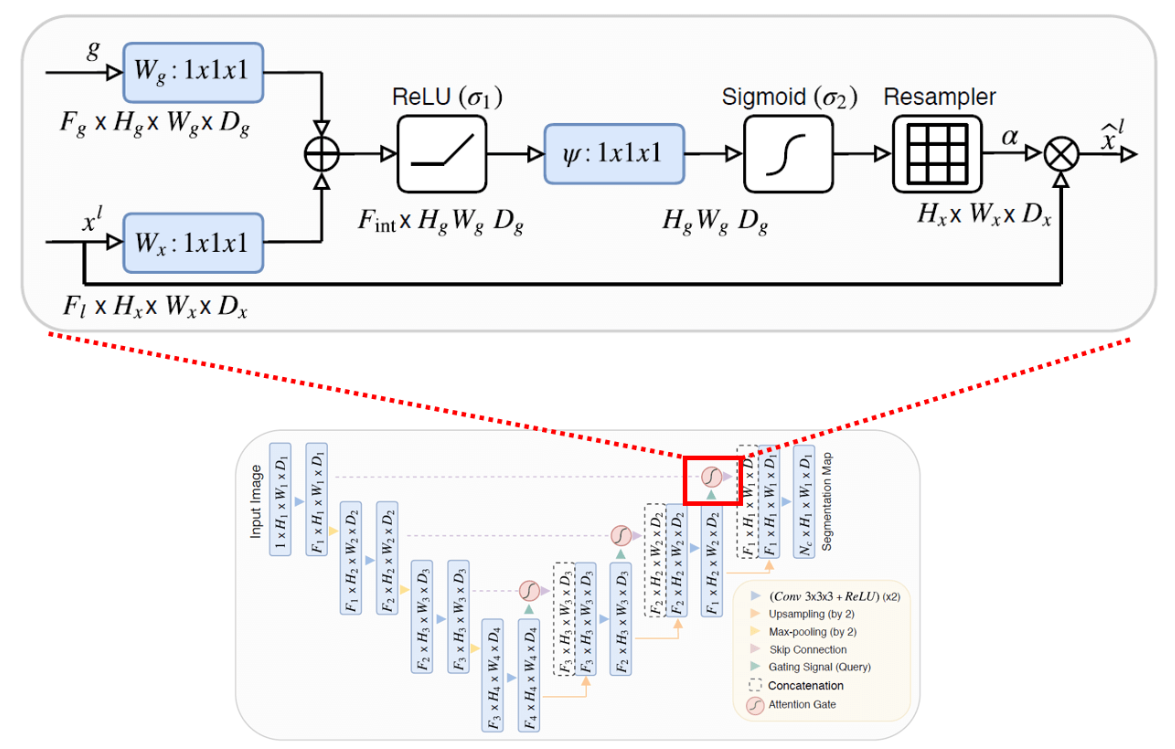

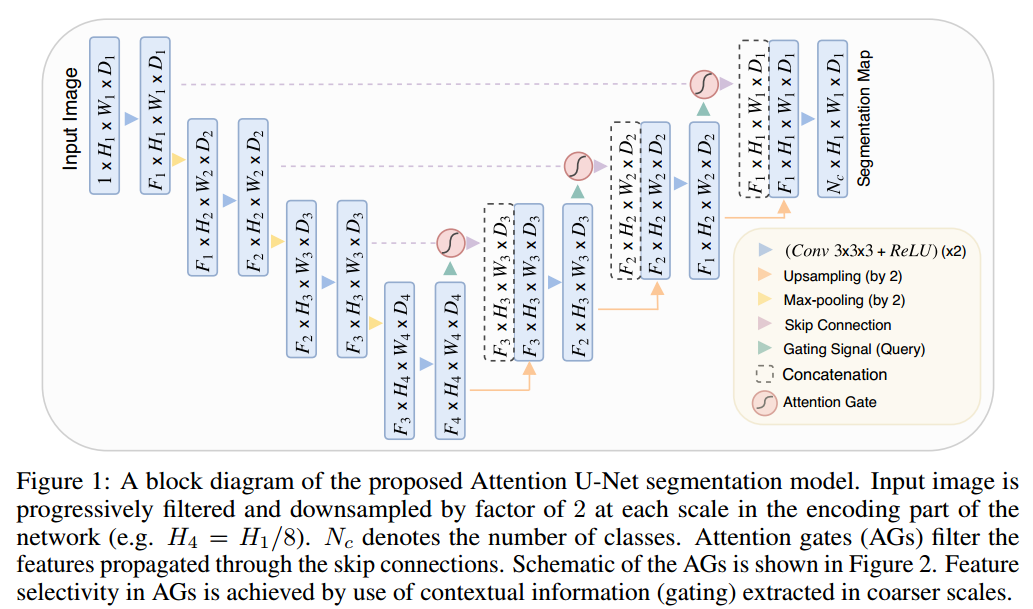

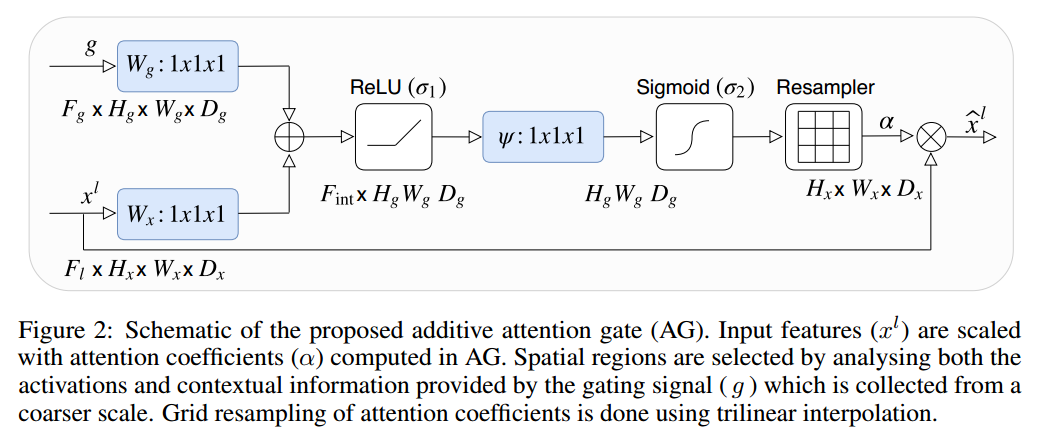

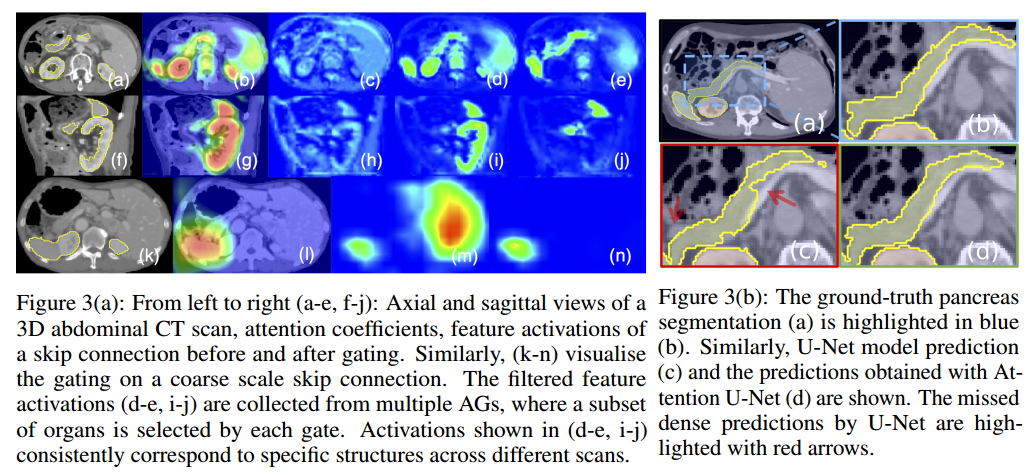

- 在网络的编码部分,输入图像在每个尺度上以2的倍数逐步滤波和下采样(例如H4 = H1/8)。Nc表示类的数量。注意门(AGs)过滤通过跳过连接传播的特征。AGs的示意图如图2所示。AGs中的特征选择性是通过使用在较粗尺度上提取的上下文信息(门控)来实现的。

- Attention U-Net的优势主要与图像多尺度特征提取有关。粗糙的特征地图捕获上下文信息,并突出前景对象的类别和位置。多尺度提取的特征图通过跳跃连接进行合并,将粗层次和细层次的密集预测结合起来,如图1所示。

注意力门控(Attention Gates)

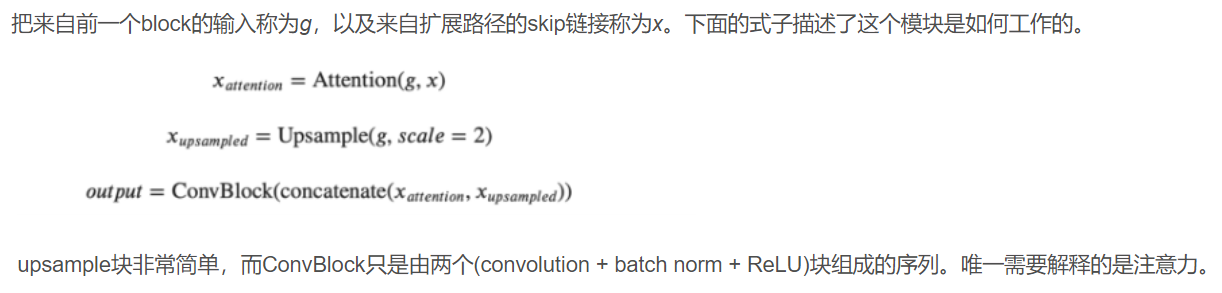

- 在UNet中,可将收缩路径视为编码器,而将扩展路径视为解码器。UNet的有趣之处在于,跳跃连接允许在解码器期间直接使用由编码器提取的特征。这样,在“重建”图像的掩模时,网络就学会了使用这些特征,因为收缩路径的特征与扩展路径的特征是连接在一起的。在此连接之前应用一个注意力块,可以让网络对跳转连接相关的特征施加更多的权重。它允许直接连接专注于输入的特定部分,而不是输入每个特征。将注意力分布乘上跳转连接特征图,只保留重要的部分。这种注意力分布是从所谓的query(输入)和value(跳跃连接)中提取出来的。注意力操作允许有选择地选择包含在值中的信息。此选择基于query。总结:输入和跳跃连接用于决定要关注跳跃连接的哪些部分。然后,我们使用skip连接的这个子集,以及标准展开路径中的输入。

胰腺和腹部图像分隔

附录与补遗

无

关于文献

题目及期刊

题目:Attention U-Net: Learning Where to Look for the Pancreas

注意力U-Net:学习在哪里寻找胰腺

期刊:arXiv

作者信息

作者:Ozan Oktay

发表时间

日期:2018年4月

阅读时间

日期:2024年8月20日

开源代码及其它

Github:https://github.com/bigmb/Unet-Segmentation-Pytorch-Nest-of-Unets

https://github.com/LeeJunHyun/Image_Segmentation

https://github.com/ozan-oktay/Attention-Gated-Networks?tab=readme-ov-file (作者)

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 YuJiang's Long Holiday!