用于荧光显微镜成像的无配准3D超分辨率生成深度学习网络

论文主体思路

论文主要贡献

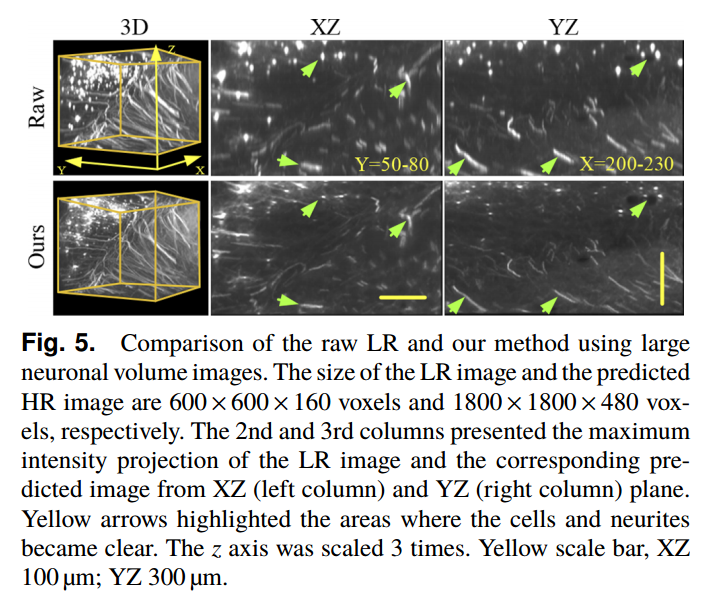

- 图像超分辨率(SR)方法为从低分辨率(LR)图像中恢复HR图像提供了一种有效的方法。这些方法需要像素级配准的LR和HR图像,这对准确的图像配准提出了挑战。为了解决这些问题,我们提出了一种新的无配准图像SR方法:直接对未配准的LR和HR体积神经元图像进行SR训练和预测。该网络建立在CycleGAN框架和基于注意机制的3D UNet基础上。

- 提出了一种无配准的超分辨率生成深度学习网络(RFSRGDN),实现了无需图像配准的3D脑显微镜光学图像的无监督超分辨率重建。该网络基于CycleGAN框架,将超分辨率视为LR/HR图像域自适应,用于无监督超分辨率训练。构建了基于注意机制的三维U-Net网络作为骨干网络,对神经元区域进行准确的聚焦。我们将3D感知损失与GAN损失相结合来捕获HR图像内容特征。

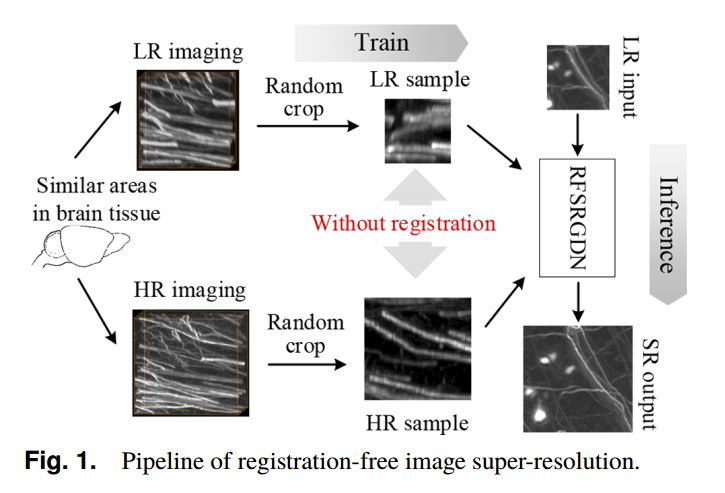

无配准图像超分辨率流程

- 低分辨率(LR)和高分辨率(HR)图像数据集由两种成像系统从同一脑组织的相似区域获得。

- 在训练阶段,我们分别在LR和HR数据集中随机裁剪图像块。HR图像的大小是LR图像的3 × 3 × 3倍。然后将随机裁剪的LR/HR图像直接输入到RFSRGDN中。训练完成后,我们将LR图像输入到RFSRGDN中的超分辨率(SR)网络中,得到超分辨率图像。

RFSRGDN网络结构

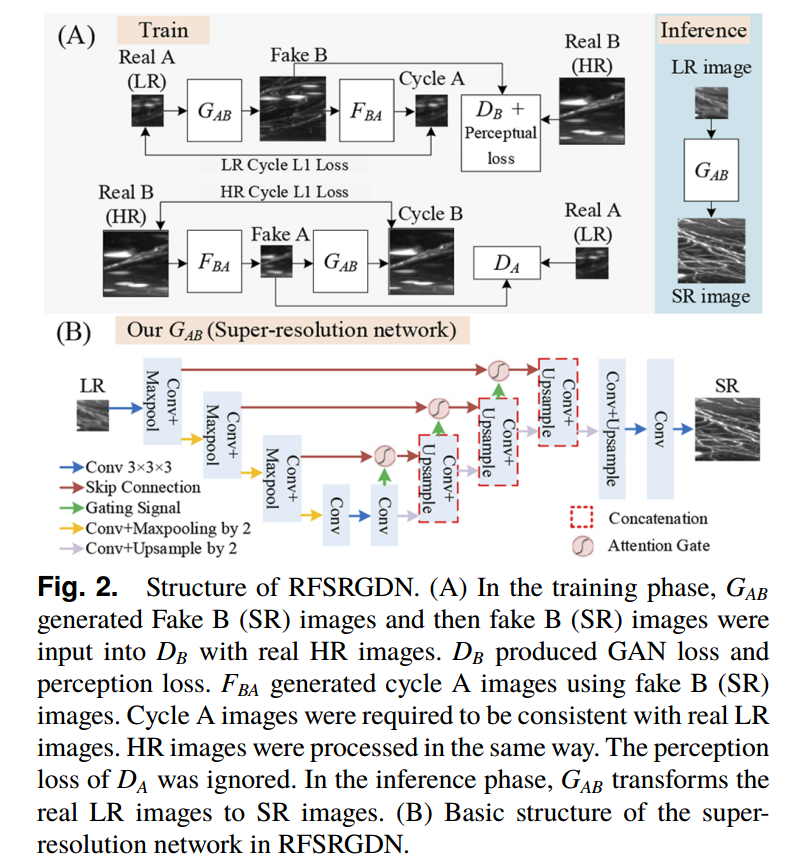

- (A)训练阶段,G(AB)生成假B(SR)图像,然后将假B (SR)图像与真实HR图像一起输入D(B)。D(B)产生GAN损失和感知损失。F(BA)使用假的B (SR)图像生成周期A图像。周期A图像要求与真实LR图像一致。HR图像的处理方法相同。忽略D(A)的知觉丧失。在推理阶段,GAB将真实的LR图像转换为SR图像。(B) RFSRGDN中超分辨率网络的基本结构。

- RFSRGDN建立在CycleGAN框架之上。CycleGAN可以在不需要像素级映射的情况下实现不同图像域的变换。我们利用CycleGAN将低分辨率(LR)图像域转换为高分辨率(HR)图像域,从而实现无配准的图像超分辨率(SR)。

- RFSRGDN由四个网络组成:超分辨率生成网络GAB、退化网络FBA、低分辨率图像鉴别网络DA和高分辨率图像鉴别网络DB(图2 (A))。GAB是用于图像超分辨率的目标超分辨率网络。FBA可以将HR图像降级为LR图像。训练DA来区分LR/退化图像。DB被训练来区分HR/SR图像。FBA和GAB的训练导致生成的退化和SR图像接近真实的HR和LR图像,使得DA和DB难以区分。这种训练权衡将推动GAB生成高质量的SR图像。

- GAB采用基于注意机制的三维UNet网络作为头部网络,然后利用3 × 3 × 3三线性上采样层和2个卷积层输出结果。由于体积神经元图像的前景比相对较小,引入注意机制捕获感兴趣区域的信息。GAB的详细结构如图2(B)所示。注意机制的设计在文献[14]中有描述。FBA、DA和DB都是全卷积网络结构。FBA包括6个卷积层和1个最大池化层。DA包括5个卷积层和3个最大池化层。DB包括11个卷积层和5个最大池化层。所有网络中卷积层的核大小均为3 × 3 × 3。

数据集信息

- 我们选择了1张1000 × 1000 × 450体素的LR图像和3张1800 × 1100 × 400体素的HR图像作为训练数据集。高分辨率和低分辨率图像都在皮层区域附近被裁剪。将低分辨率和高分辨率图像随机裁剪为48 × 48 × 48体素和144 × 144 × 144体素大小的图像块,送入RFSRGDN进行训练,不进行配准。

- 训练的初始学习率设置为5 × 10−4,使用步长调度器进行学习率迭代,gamma值为0.9。采用Adam优化器对超分辨率生成网络和图像退化网络进行了优化。整个网络是使用PyTorch构建的。培训在Intel I7 12700F和NVIDIA RTX 3090平台上进行。我们训练网络超过300次,大约14小时,以达到超分辨率。

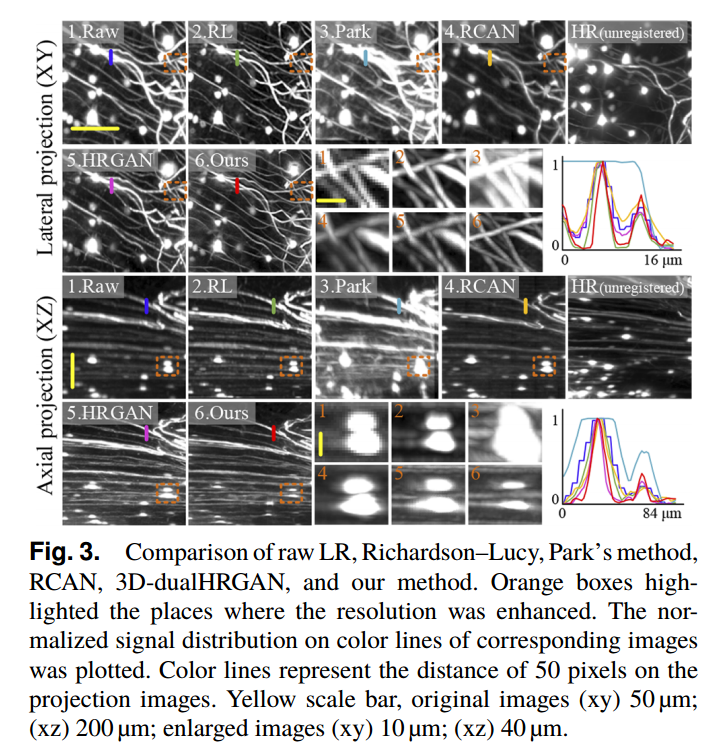

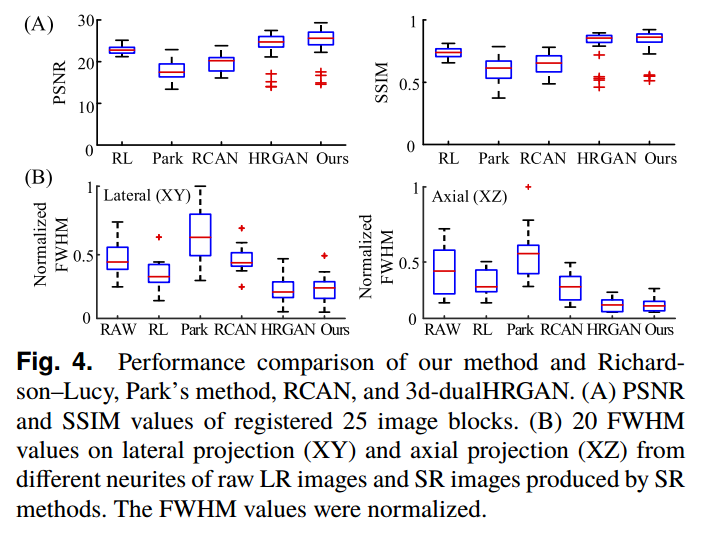

方法比较

附录与补遗

无

论文中可以引用的部分

无

关于文献

题目及期刊

题目:用于荧光显微镜成像的无配准3D超分辨率生成深度学习网络

Registration-free 3D super-resolution generative deep-learning network for fluorescence microscopy imaging

期刊:OL

引用

- Zhou, H., et al. “Registration-Free 3d Super-Resolution Generative Deep-Learning Network for Fluorescence Microscopy Imaging.” Opt Lett 48.23 (2023): 6300-03. Print.

作者信息

作者:Hang Zhou,Yuxin Li, Bolun Chen,Hao Yang,Maoyang Zou,Wu Wen,Yayu Ma,Min Chen

发表时间

日期:2023年

阅读时间

日期:2024年10月28日

开源代码及其它

GitHub:https://github.com/artzers/RFSRGDN (作者)

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 YuJiang's Long Holiday!